Bienvenue sur le projet OMS (Optimization on Measures Spaces).

ANR JCJC début 2018 – fin 2020.

Comment optimiser une mesure structurée ? De tels objets peuvent modéliser des pics parcimonieux en superrésolution, des trajectoires d’échantillonage en IRM, des contours dans des images… Nous cherchons à développer de nouveaux outils théoriques et informatiques pour s’attaquer à ces questions, et à les appliquer à des problèmes contemporains.

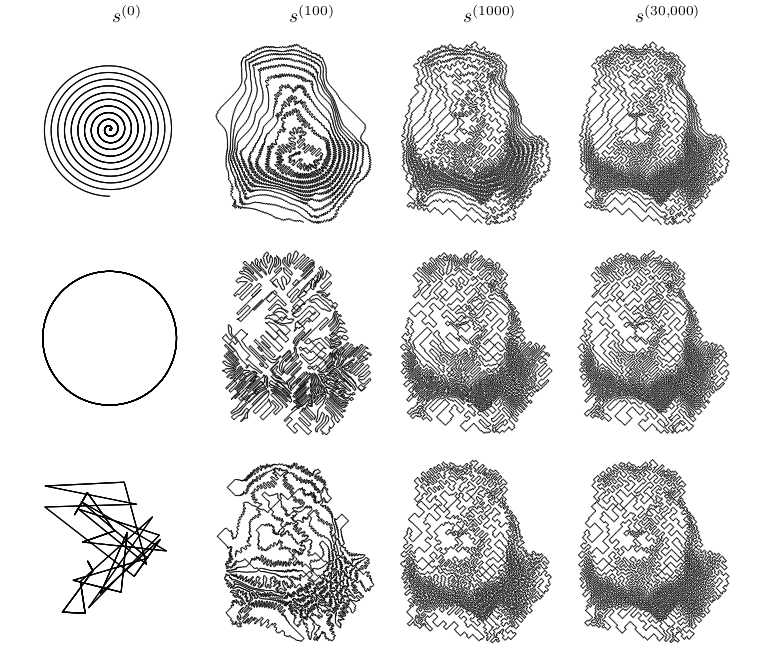

Dynamique d’un de nos algorithmes de projection: en partant de toute courbe, la suite de mesures converge vers l’image d’un lion.

Résumé étendu :

De la quantification aux problèmes inverses en dimension infinie, pour n’en citer qu’une paire, de nombreux problèmes peuvent s’écrire comme un problème d’optimisation où la cible est une mesure.

Un cas particulier typique est l’approximation de mesure, qui correspond à une projection. Un cas simple de ce problème est le halftoning, qui est à la base des imprimantes à jet d’encre. L’image peut être interprétée comme la mesure cible, et les mesures autorisées sont les ensembles de N atomes de poids 1/N. Plus généralement, nous pouvons chercher à minimiser toute fonction sur un sous-ensemble des mesures de Radon sur une variété de dimension d.

De nombreux algorithmes ont été créés pour résoudre des exemples de ce problème. Ils incluent des approches à la Galerkin, des algorithmes gloutons, du lifting ou des hiérarchies de Lasserre. Ces approches fonctionnent bien pour des problèmes peu complexes, mais sont bien trop lentes ou imprécises pour certaines des applications que nous visons dans ce projet.

Lors de précédents travaux, nous avons utilisé le fait que tout sous-ensemble des probabilités de Radon est une limite en distance de Hausdorff d’ensembles de mesures à N atomes. C’est très naturel pour les courbes vues comme des mesures image, ou plus généralement pour des ensembles de sous-variétés structurées. Nous avons ainsi développé un algorithme très souple pour résoudre la version discrétisée du problème d’optimisation.

L’avantage principal est qu’il n’y a que Nd variables, si bien que la complexité est linéaire en la dimension. De plus les mesures à N atomes peuvent souvent approcher plus vite les mesures cible que des discrétisations plus traditionnelles. Par exemple, comme nous ne travaillons pas sur une grille, les atomes peuvent être placés précisément.

L’inconvénient est la non-convexité de l’optimisation. Nous n’avons donc que peu d’espoir de trouver un minimum global. Le problème de Thomson, qui est vieux de cent ans et l’un des problèmes de Smale, n’est qu’un cas particulier. Nous étudierons donc les points critiques et les minima locaux.

Le projet vise à améliorer les outils sous-jacents à nos algorithmes, à leur donner des garanties théoriques, et à utiliser ces techniques pour des applications réelles.

Tout d’abord, nous chercherons des discrétisations pour des ensembles typiques de mesures, qui approchent rapidement l’ensemble, et permettent des calculs faciles. Nous améliorerons et généraliserons les outils géométriques, comme la transformée de Fourier rapide non-uniforme ou les diagrammes de Laguerre. Nous voulons développer ces outils pour des courbes, entre autres, au lieu de points.

Ensuite, nous voulons prouver la convergence de nos algorithmes, et en créer de nouveaux au besoin. Une fascinante question théorique générale est de comprendre pourquoi un algorithme converge vers une solution presque optimale malgré la non-convexité, comme cela semble le cas en pratique.

Enfin, nous appliquerons nos outils à l’optimisation des chemins d’acquisition en IRM et pour la reconstruction d’images super-résolues en microscopie, en envisageant des brevets. Nous explorerons d’autres applications comme la détection de filaments galactiques.

Ce projet regroupe des chercheurs sur Toulouse, à l’expertise variée et complémentaire. Le PI Jonas KAHN (CNRS, IMT) couvre un large spectre en maths pures et appliquées. Il est membre de la nouvelle équipe-projet sur l’apprentissage (AOC) à l’IMT, ainsi que de l’équipe de bio-imagerie PRIMO à l’ITAV. Pierre Weiss (CNRS, ITAV) et Frédéric de Gournay (IMT) y appartiennent aussi. Leur travail sur l’IRM et les distances de transport est à l’origine du projet. Ils sont spécialisés dans l’analyse numérique et l’implémentation d’algorithmes. Jérôme Bolte (TSE) est un spécialiste reconnu de la théorie de l’optimisation. Léo Lebrat a commencé son doctorat sous la direction de Jonas Kahn et Frédéric de Gournay en octobre 2016.